當我們說CPU、GPU乃至於TPU無法應付機器學習「可能」的運算需求,有兩個事情是我們所在乎的:運算速度以及耗能。

一般的創業家和投資者比較能夠理解運算速度的重要性,畢竟整個深度學習的大躍進就是在於過去得花上幾週甚至幾個月才能完成的神經網路運算,被降到幾天甚至幾小時,但較少創業家或投資者能夠理解耗能的重要性,因為在過去十餘年的精實新創浪潮中,耗能這種東西百分之百是高通、鴻海、蘋果和三星這些人的問題。

但是在機器學習中「耗能」是一個很大的挑戰,甚至會成為效能的障礙。機器學習的耗能主要來自兩個領域:

(一)矩陣乘法:所建置的神經網路越多層,每一層的神經元數越多,所需要運算的矩陣乘法就愈多。而半導體邏輯晶片的乘法是由NAND閘組合出來的,每一個電晶體的節點都會在電壓上下擺動的過程中消耗掉能量。考慮到矩陣乘法所需要用到的邏輯閘數量驚人,而且隨著神經元和係數的增加以指數成長,這部分運算的耗能也就指數成長。

(二)記憶體存取:類神經網路的運算需要大量而且高速的記憶體存取,主處理器(不論是CPU或者GPU)和記憶體模組通常是不同的晶片,因此存取發生在印刷電路板上,大量的能量會被耗損在對抗印刷電路板和晶片封裝的雜散容和電阻上。

耗能劇烈的第一個影響是電力成本。以去年擊敗李世乭的AlphaGo為例,該系統使用了1920個CPU和280個GPU,光下一場棋局的電費就高達三千美元,相較之下李世乭本人下這場局可能只需要一兩碗飯的熱量,「電」腦和「人」腦在耗能效率上仍然有天壤之別。

但是如果做多少運算就付多少電費就能解決的話,那還好說。但耗能的最大問題是:不管是哪一種耗能方式,都會轉換成廢熱,這些廢熱必須排出去,才能讓系統正常運轉。但系統耗能產生廢熱的速度根據運算量成指數成長,排除廢熱的速度卻受限於熱力學和流體力學有著線性的特質,因此我們不難想像在邁向泛用型人工智慧的路上,我們可能會先被「熵」這個躲也躲不掉的敵人給擋住,而不是演算法。

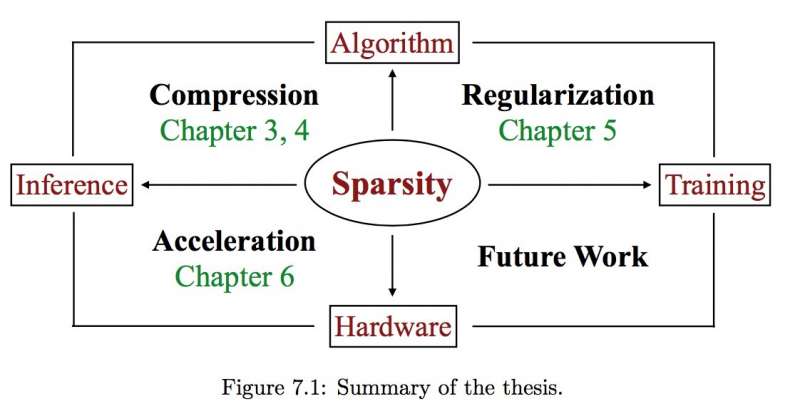

在Song Han的講座中,他介紹了各種軟體演算法和硬體晶片結構的協同最佳化,以應付機器學習中training和inference兩個部分的耗能效率挑戰。但是不管是哪一種方式,不管改善多少運算效能和耗能效率,從工程的角度來看都是短期的、貼貼補補之類的解決方案,在摩爾定律多年前早已停止改善耗能的事實下,這些方案並沒辦法提供一個康莊大道通往真正的人工智慧經濟學終局。

這也是作為風險資本投資者,我們致力於尋找著半導體邏輯運算以外的解決方案的原因。在之前專欄〈量子電腦春暖花開〉中我所介紹過的量子電腦是一種,而且理論上是最能夠應付無限延伸的未來中機器學習運算需求的一種。但量子電腦的問題在於,目前不管是新創或者谷歌、IBM乃至於Intel等大廠的系統,都必須把溫度降到絕對零度附近,才能進行量子運算,地球上的降溫系統本身就是一個極為耗能的裝置,要等到綜合能源效率和建置成本到達可以和半導體晶片相比擬,恐怕還要不少的時光。

那麼有沒有其他的方式能夠比半導體有著高許多的耗能效率,但又沒有量子電腦那接近絕對零度的挑戰呢?答案也許存在自然界裡,就像是量子電腦採用物理特性進行運算,自然界也有許多物理現象包含了矩陣乘法的特質,也許我們可以找到一種運算方式,是將資料轉換成自然界的物理現象,在那裡完成運算,然後再匯回電腦系統中。這種運算統稱為「類比運算」(analog computing),其實是一門很古老的學問,遠在數位晶片高速成長的年代之前,幾乎所有的運算都是在類比世界中發生的。

作為投資者,我尋找著也等待著能夠善用類比運算來大幅加速機器學習的創業家,如果能夠投資到這樣的新創,我不介意錯過Blue Apron這樣的投資機會一百次!

*作者為台灣大學電機畢業,在台灣、矽谷和巴黎從事IC設計超過十年,包含創業四年。在巴黎工作期間於HEC Paris取得MBA學位,轉進風險投資領域,現為Hardware Club合夥人。