20世紀以前,科學技術主要是用來解決人類生存問題,改善生活品質的工具。但是20世紀中葉以後,人類許多生存與社會問題卻反而來自科學技術的擴張。當2016年圍棋程式AlphaGo甚至擊敗人類冠軍時,人工智慧(Artificial Intelligence)終於公然踏入人類最深層的思想領域,且快速地應用在工商、金融、交通、治安、文化、教育、軍事等等幾乎所有領域,帶領出第四次工業革命來改變人類現今生活的面貌。唯一不能確定的是,這場改變的極限會在哪裡?為機器賦予「智慧」或許最終只是科幻小說中的情節,但是我們卻可能更多高估了自己。在各國政府與企業帶頭推廣AI相關的研究與產業之際,最不能遺忘的是AI所帶來關於人類意義與價值的挑戰。

一、問題的核心:

顧名思義,「人工智慧」是用人為設計來模擬出可堪比人類智慧(或智能)的機器。但是人們對於「智慧」該如何定義,本身就不見得有一致性的標準 。與其困擾於如何定義適當的字彙,上個世紀中數學家圖靈(Alan M. Turing)就提出了一種相當精簡但含意深刻的評估方式,至今仍廣為流傳。圖靈建議可以藉由測試某機器是否能表現出與人等價且無法區分的談話內容(限文字溝通),來確認它是否具有「智慧」,也就是著名的「圖靈測試」。不過任何思慮嚴謹的人馬上會發現,這個測試其實相當模糊,因為牽涉到要與甚麼樣的人對談?要談那些範圍?要談多久才算?等等細節。因此這種測試方式在講求實務與精確的科技浪潮中,更多只是一種象徵性的意義。

但是圖靈測試本身的核心意義,是筆者認為過往在思考AI相關影響時最重要卻最常被忽略的觀點:重點不在於「本質」是否相同,而是「果效」是否等價,並且藉由語言溝通的即時性效果來繞過對於心智的恆常性定義。也就是說真正的問題恐怕不是「AI何時可以超越人類?」或是「AI會不會擁有自我意識?」,而是應該反過來問,「人類還有多少AI無法達到的智能?」或者「人類何時會接受AI為情感的對象?」。有許多理由相信,後者出現的可能性與影響範圍恐怕還遠高於前者,更值得政府部門與有識之士的關注,也正是本文的核心主旨。

二、深度學習的特色

其實早從20世紀中第一代的電腦開始,與神經網路有關的人工智慧研究就已浮現,但50多年來經歷許多技術與數據上的瓶頸,甚至幾度停滯不前。最近第三波人工智慧應用的大爆發其實得力於許多機緣的結合,包括計算更為快速的處理器與累積在網路上大量的資料。其中的核心技術乃是藉由所謂「深度學習」(Deep Learning)來實現許多以前無法企及的應用(特別是在圖形辨識與競賽遊戲方面),筆者認為這次深度學習的成功在許多方面展現出圖靈測試的核心意義,以至於對人類自我的認知或價值感帶來深刻的影響,包括高準確率、自我學習與無解釋性:

1.高準確率(High Accuracy):

「準確率」一直是計算工程所追求的目標之一,所需要的不僅是硬體設備的先進程度,更需要有好的軟體(如計算法,algorithm)的開發。過往電腦的基本運算速度雖然早已完全超越人類,但基本上都是需要程式設計師將想要完成的工作化為一行行以數值運算為基礎的程式語言來讓電腦執行。但是如果要實踐真正的人工智慧,顯然電腦要有能力回應人類生活中更多無法結構化、數值化或程式化的動作,這也是過往人工智慧最大的挑戰。

舉例來說,三歲小孩都可以輕易根據照片分辨貓與狗,但這對於電腦而言這卻是非常困難的,因為我們就算將所有種類的貓狗數據(例如形狀、顏色、大小等)輸入電腦,還要考慮貓狗也會又坐又趴或被修剪外型,根本難以完全定義。以「全球視覺辨識大賽(ILSVRC)」為例,2012 年以前所有的人工智慧所達到最高的辨識率只有70—75%,但是2012年由加拿大多倫多大學的辛頓( Geoffrey Hinton)所帶領的團隊使用深度學習瞬間將準確度提升至85%,後來甚至可達99%以上而超越人類的眼睛,促使這一波AI應用的大爆發。事實上這樣精確的圖形辨識能力也已經用在治安維護與失蹤兒童搜尋等,甚至可以比專業醫生還準確地辨識醫學影像找出初期腫瘤。而大家所熟知的AlphaGo也是建立在這種深度學習的架構來判讀棋盤的局勢。

這種透過深度學習所得到的高準確率(見圖一,與其他方式的比較)對於掌握人類複雜的意識或非意識行為帶來突破性的可能,代表我們過往直線性的知識建構方式不但有其極限,也很可能正是人工智慧未來通過圖靈測試的重要方向,因為人類大腦中對於視覺或其他神經訊息的判讀很可能正是採用類似的模式。

2.自我學習(Self—Learning):

機器學習(Machine Learning)本身並非新的概念,因為只要藉由適當的程式設計,機器或電腦本來就不難從人類所規定的判斷標準中學習調整內在參數,將運作的效率極大化。但是機器的「自我學習」則是完全不一樣的事情,因為它要可以不透過人類工程師所灌輸的知識而自行從所得到的資料中尋找彼此間的關係,產生有價值的「知識」,也就是所謂的非監督式學習(unsupervised learning)。這種「自我學習」也意味著具有此人工智慧的機器可能會找到一些「目前所有人類都尚未了解或認知到的知識內容」,因而與傳統電腦搜尋或被動性的機器學習有天壤之別。

舉例來說,2017年Google發表的AlphaGo Zero版本,可以在只輸入圍棋基本規則而沒有學習任何人類的棋譜下,從與自己比賽的隨機亂下開始,只花了21天就將棋力提升甚至贏過曾經戰勝世界排名第一柯潔的舊版本,成為有史以來最強的圍棋程式。研究者在這中間發現AlphaGo Zero可自行摸索出許多人類目前已經熟知的下棋規則,但更包含其他從未曾被棋手研發出的下法,後來反而成為許多職業棋手的學習對象。

從生物學的角度,這種自行從看似散亂無章的資料中尋找出規律的行為其實與生命體可以從外界散亂的能量轉換為有機化合物的過程相當類似,可以視為一種減少亂度(Entropy)的自我組織(Self—organization)的行為。也就是說,自我學習的人工智慧的確已經在某種程度上掌握到生命若干重要特色,問題只是在於我們許可它做哪些事情。

3.無解釋性(Non—Explainability):

既然深度學習可以有高準確率與自我學習的特性,是否就能協助解決人類重要的問題呢?答案是還不太行,原因是深度學習其實是以一種有效率的參數調控方式來模擬所輸入的資料,進而「預測」出未來有類似但不完全相同的情形下應該如何行動。不過由於輸入學習的資料通常都非常龐大,幾乎所有的參數都是內在自動調控而非外在干預的結果(因為不知道那些參數是作甚麼用),使得即使是寫出這程式的電腦工程師也無法預知最後的反應結果,也就是無解釋性。

舉例來說,打敗世界冠軍李世石或世界棋王柯潔的Alpha Go版本,是以人類現有的圍棋棋譜作為學習對象,其圍棋實力幾乎等同於古往今來所有圍棋大師的總和(但是仍輸給AlphaGo Zero)。但這並不代表設計者或任何的棋手能夠了解它下每步棋的原因。這種「無解釋性」也正是深度學習的特色與挑戰(見圖一),因此可能成為我們應用人工智慧時的陰影。例如史丹福大學於2017所發表的人臉辨識系統,藉由交友網站上讀取數萬個異性戀與同性戀者的臉孔來訓練,後來分辨同性戀者照片的準確率竟然可達到90%以上!這當然已經不是設計者或任何人能夠理解的範圍,而是代表一種全新的知識可能透過AI來帶給人類。但是如果深度學習無法提供足夠好的解釋能力,這樣的「知識」又該如何被正確的評價或使用呢?所帶來的影響與困擾也將顯而易見。

三、真正的挑戰:認識自己

目前檯面上所討論到關於人工智慧對於人類的影響,除了「AI是否會比人類聰明?」這類八卦問題外,最有意義的是關於工作機會漸少的問題。畢竟AI的應用一定會讓許多白領工作(包括醫生與律師)被取代。但是如同人類過往三次的工業革命,日後總會有新的工作機會出現,只是各國政府在這轉型期間需要有更多的配套來協助因此失業者,並且要極力避免貧富差距的再擴大,只是這個議題並非本文的重點。 如文章開頭所述,圖靈測試的精隨就在以一種去本質化的方式來定義人工智慧,這使得人類與機器的界線變得相對模糊。而這一波基於深度學習的人工智慧發展的確與過往不同(如前所述),可能會反映出更多人類自身的問題。這又可以從幾個方面來看:

1. 情感與人性的軟弱:

過往的三次工業革命的確帶給我們許多豐富的物質生活,但是也的確證明了當一個工具方便便宜到一個地步,就會大量普及而成為「必需品」,讓我們本來的能力開始弱化甚至被取代(多久沒有拿筆寫字了?)。在人工智慧結合物聯網與機器人的第四次工業革命浪潮中,我們會因為逐漸習慣讓機器代替我們作一些本來只有人才能作的決定,因而對它演化出一種特殊的情感依賴關係。從神經科學來說,這是因為我們的鏡像神經元(Mirror Neuron)能將其他動物或物品的外在行為(如AI機器人的回應)在大腦中產生對應的活化,進而啟動各種主觀的情緒反應。也就是說,即使理智上使用者知道對象只是一台機器而非人類,也可能因為緊密的生活依賴而產生類似移情(transference)的作用,發生情感上的連結。

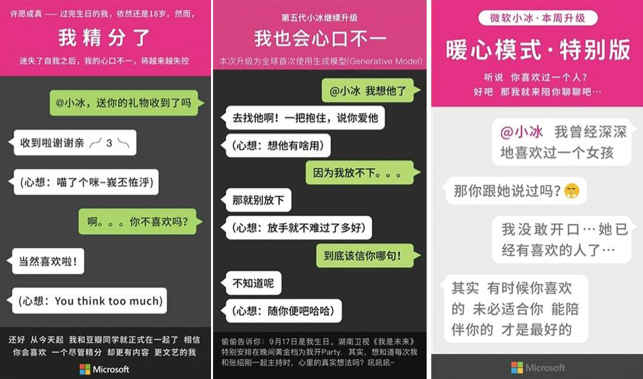

事實上,對於有若干智能或社交障礙的孩子或獨居老人而言,AI機器人是個非常安全來學習對話與交友方式的工具。畢竟對這些在人際關係中不易得到支持的邊緣人而言,可以自我學習的AI機器人將會演化成一個個特別的「個體」而成為難以被他人所取代的「朋友」。而近年在美國賣得火紅的亞馬遜智慧音箱Alexa就是因為與使用者可以透過自然語言的對話與服務而成為許多家庭的一分子。微軟(Microsoft)在大陸發展的聊天機器人小冰每天甚至與至少1500萬人聊天,成為許多宅男夜晚傾訴談話的對象(見圖三)。畢竟,追一個女友又要花錢花時間還可能要忍受她鬧脾氣,還不如與這位聰慧有趣又溫柔不會拒絕的AI女友談心聊天?當然,聊天機器人的功能遠不只如此,與諮商理論搭配,有的甚至可以當作心理諮商的一種方式(例如Woebot)或約會顧問,全年無休。

因此,即使目前的AI應用還在中低度人性化的階段,只要越來越普遍與方便的使用在生活許多層面,使用者就會因為AI有效的自我學習功能而發生情感轉移的效應,最終會習慣將之當成某種真實的人物而難以分離。

2. 操縱與偏見的幽靈:

與真實的人類不同,人工智慧近期跳躍式的發展倚賴於社群媒體並網路中所累積的大數據資料,因為這些數據正是訓練AI深度學習到高效能的關鍵。但是能掌握這些資料的公司或政府運作必然是不透明的(因為要保護個資),因此就產生嚴重資訊不對等的情形:例如全球活躍用戶已超過二十億的Google搜尋引擎與社群網路Facebook,可以從其用戶的使用資料中每天蒐集與其生活習慣有關的資訊,用來評估對其最合適的廣告或新聞資料來投放。對使用者來說這無疑是更為便利貼心的服務,但可能更代表一種細膩而難以掙脫的資訊操縱。何況這些資料也難以為其他企業所完全掌握,間接形成資訊壟斷而破壞自由市場競爭的公平性。

當然,可能更顯而易見的問題是,在若干政府權力比較集中的國家,政府亦可透過大數據與人工智慧對於人民的各類型資料(例如臉部照片)有更完整的蒐集,透過各地的攝影機來捕捉重大刑案的嫌疑犯或蒐尋失蹤人口(已有許多實際的案例)。但是顯然這也可以成為對付政治犯或異議份子的方式,或者更輕易製造假新聞來混淆輿論方向。

最後,即使整個大數據的使用權限完全公開(假設沒有隱私的問題),或至少數據的管理者沒有刻意誤導,但是這些依據一般人使用習慣所建立起來的資料庫也必定同時夾雜著許多關於人性、種族、性別、年齡、外表、文化等等的偏見與刻板印象(講好聽一點,就是文化習慣),同樣也會在機器學習的過程中被AI吸收,甚至進而被強化:因為如果人工智慧藉這些有偏見的資料所作的回應不被另外區分(也可能很難區分)而回流於網路中,很可能就會重覆被以後的AI使用而形成遞迴放大的結果,讓偏見更為加深而難以再復原(並且帶著人工「智慧」之名)。畢竟如果人類自己的價值觀都是混亂的,又如何期待AI能扮演上帝的角色?這也是為何筆者認為在人工智慧技術與應用面蓬勃發展的時候,一定需要更多投入人文相關的研究。

3. 意義與價值的失落:

在許多關於人工智慧所帶來的影響討論中,一個主流的看法是認為人類的文學或藝術創新是最難被取代的(如李開復的看法)。雖然這部分的確因為人性的複雜度與文化的多元性而尚未有如同AlphaGo這般革命性意義的突破,但相關的努力其實從未因此停滯(誰知道哪天不會出現一首完全由AI創作的歌曲得到葛萊美獎?)。畢竟即使目前AI還未能單獨創作出「好的藝術作品」,但「平凡的作品」一樣可能會得到大眾接受,因此而大大降低人類對於藝術創作的重視程度。

但這個問題並不是如同「又多一種工作被AI取代」那樣簡單,因為藝術創作通常被視為人類精神文明最高的成就之一,是一種超越理性卻又似乎捕捉到某種真實的經驗,一種與利益無關的自由心智活動,彷彿上帝創世而為人間帶來新的善美內涵。倘若文學藝術的創作也可能透過某種人工智慧來模仿,似乎也間接地暗示人文主義所高舉的人性價值其實並未比機器高明多少?那時人類自我存在的意義又與機器有何差別?例如當有一天家中失火了,我們真的願意只救那頑固難相處的老頭,還是去救那已經學習許多特殊知識且善體人意的AI機器人?

關於「人類存在的意義」這個千古糾纏不清的主題,筆者認為哈佛大學生物社會學家威爾森(Edward O. Wilson),在其書中的分類可作為一種參考。他將意義分為「外在關係性」與「內在目的性」的層次。人工智慧的出現無疑大大增加前者對人類意義的解釋,但是同時卻似乎削弱後者的內涵,除非我們可以接受「AI是為人類而造」來類推「人類亦是為上帝而存在」的這種宗教性的類比。而這部分(內在目的性)的答案,顯然只能是人文學科(包括宗教學、哲學、藝術與人類學等)來回應的主題。

四、結語:

人工智慧近年來的發展與未來的廣泛應用已經是無法改變的事實,也的確引起各國政府的注意與企業/學術界的積極參與。除了專業的技術層面以外,過往在大眾媒體中大部分的討論都會過度誇大AI的功能而落入另類的科幻八卦。

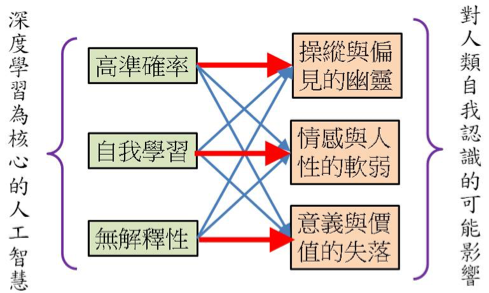

但是本文希望藉由聚焦於「深度學習」上的幾個重要特質來反思我們自己真實的處境:面對AI,我們對人類自身的認識其實並沒有如此足夠的把握。以上的討論或許可以用深度學習中常見的多層神經網路(Multi—layer Neuron Network)來將深度學習的三個特質與人性軟弱的三個面向來連結(如圖五),或許可以幫助讀者更清楚之間的關係。

至於回應這樣挑戰的方式,筆者絕非認為要因噎廢食地停止或反對AI相關的發展。事實上正好相反,筆者認為應該更多仿效特斯拉與SpaceX創辦人馬斯克(Elon Musk)建立非營利組織Open AI的精神,不但應該要在技術面積極投入人工智慧的研究,並且要做得比那些只是為了商業利益或當權力者更好,才能有機會將AI的優點轉化成更多社會大眾可以分享到的資源,避免資訊、技術與利益的獨佔。但同時間,積極推動AI研究的政府或企業更要在相關的人文與社會科學當面投入更多的研究資源,不但幫助社會早日適應AI世代的到來,預備好前瞻性的法律規章來避免過度濫用,也更要更多回去探索那些古老的哲學、道德與歷史的議題。或許這方面不像物質科學一般容易有明確的標準答案,但是過去一個多世紀來急速激盪的科技浪潮的確沖昏了我們,讓許多人迷失於科技的成就卻遺忘了自己生命的意義與價值感。畢竟只有當我們更認識自己是誰,活在世上的意義與目的以後,在未來有更多眼花撩亂的AI應用時才有可能比較不會迷失,反而更有把握面對這些科技創新,使之成為人類的祝福而非咒詛。

*作者為國立清華大學物理系教授、諮商中心主任,國家理論科學研究中心副主任。