在卡夫卡的經典小說《審判》中有一則寓言《法律之前》,講述一名鄉巴佬試圖上法院尋求救濟,到了門口卻被警衛阻擋的故事。警衛說:「法律的大門為人人敞開,不是不給進,但不是現在。」鄉巴佬在門口探頭探腦,警衛看著他著急的模樣,笑說:「門沒關,你夠膽就衝進去,但要記得我只是最低階的小看門,裡面每間房都有警衛,個個不好惹。」鄉巴佬只好坐在警衛給的小板凳上枯等。數年之後,鄉巴佬無奈之下掏出囊中所有金錢賄賂警衛,希望不要得其門而不入。警衛笑納之後說:「我還是不能放你通過,收下這份禮物只是不想讓你覺得徒勞無功而已。」鄉巴佬聽完,既不憤怒,也不打算傷害警衛,而是繼續在門前等待,直到死前。在他嚥氣前,鄉巴佬問警衛:「人人都想在法律之前討個公道,為什麼這麼多年來我一個影子都沒見到?」警衛說:「你眼前這扇門,是特別為你準備的,而我現在要將它永遠關上。」故事至此嘎然而止,讀者只能假設,然後鄉巴佬就死掉了。

《審判》的男主角K在聽完這則寓言後,認為整件事就是一場用謊言羅織而成的體制化騙局。卡夫卡式法庭不在乎客觀世界中的真實,而僅在乎維持體系的持續運作。法律的大門理論上向社會敞開,但在卡夫卡的世界裡,看似人人有機會,其實個個沒把握。整個體系不是在追求真理正義,而是在為維護體制的充分與必要條件服務。當偏見已經根深柢固,只要身在其中,就被推定有罪,取證、詰問、辯論等程序,只是過場套路。恪忠職守的各級官僚不用為受害者負責,更無需內疚自責。因為他們都像那位低階警衛一樣,只是盡看門的本分而已。制度殺人,莫此為甚。

對關注人工智能進展的人士而言,卡夫卡筆下的絕望困境,象徵著一種反烏托邦式的惡夢。藏在一扇扇森嚴大門之後的法官,是至高無上的絕對權威。整個法律體系彷彿一只神秘的黑盒子,沒有人敢質疑這套威權體制的運作邏輯,也無法明白黑箱作業的各種技巧。人類知道自己身處黑箱之中,卻不知道黑箱的邊界,只能戰戰兢兢苟活。一但違規,只能逆來順受,無條件服從安排。想像這個黑箱不是由卡夫卡式的法官、律師與警衛把持,而是由各種人工智能及大數據演算法操縱。這些用機器語言寫成的軟體程式碼,與用人類語言寫成的法律條文一樣,都不可避免地受到創造者的主觀願望與價值取向影響 — 一種偏見的結構。偏見隨時間沖刷被體制化,逐漸取得了可被稱為「習慣」、「法律」、「民情」等「正統」地位。這個自然演進的過程,在前互聯網時代,可能是漸變 。在互聯網席捲全球、快速迭代的世界,就是不斷生滅的劇變。隨著社會經濟生活演化愈趨複雜多樣,「法律」作為一種規範的上位概念,其內涵與核心價值也必須與時俱進。當掌控資源的新貴們愈發信奉數理邏輯,而非義理人情,有能力利用人類與機器語言「造法」的行為體,若不受制衡,又無法自我警惕,比卡夫卡世界更冷酷無情的人工智能專政就可能隨時降臨,所有捍衛自由、民主與人權的努力,在鋪天蓋地的技術進逼之下,將毫無招架之力。

被AI專政的世界是否已經降臨?曾在紐約對沖基金德劭集團(D. E. Shaw Group)任職的數據科學家、知名部落格mathbabe博主Cathy O’Neil在其新作《Weapons of Math Destruction: How Big Data Increases Inequality and Threatens Democracy》中認為,非常可能。

在哈佛大學主修代數數論並取得數學博士學位的Cathy,自幼熱愛數學,在獲得紐約哥倫比亞大學巴納德學院的教職之後,卻毅然決定到德劭擔任量化分析師,透過研究各種數理統計模型與數據分析,在全球資本市場中找尋可持續獲利的交易與投資策略。她與同事所做的工作成果,可以驅動數以兆計的資金在全球市場快速流動,創造鉅額財富。2008年全球金融海嘯,讓她頓覺幻滅:非關道德的數理模型成為華爾街鍊金術士口中的神奇公式,由資產證券化工廠製造出來的金融衍生商品,催生了龐大的房地產信貸泡沫,將金融體系中的槓桿推升到難以為繼的程度,加劇了金融危機的連鎖反應,甚至差一點摧毀全球經濟。

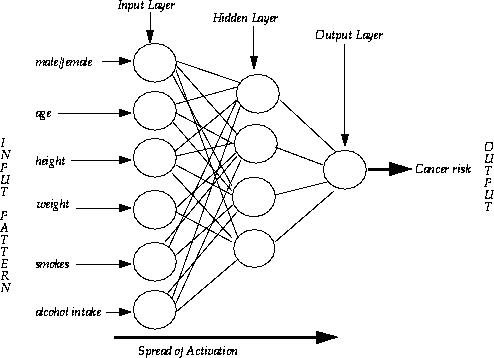

更讓她驚訝的是,金融危機爆發後,新的數據分析技術被應用至更多領域。透過日夜不停地爬梳蒐集自社群媒體、電子商務網站及各類互聯網平台的海量數據,原本用來套利套匯套差價的演算法被用以研究人類的七情六慾、預測消費口味及監控信用風險,計算個人是否值得受高等教育、獲得工作面試、購買醫療保險、甚至戀愛與犯罪的機率。但這類驅動大數據經濟的應用程式,是基於容易犯錯的人類的主觀判斷所設計的系統。系統工程師們或許出於好意,企圖客觀地找出更有效率的方式解決問題。但很多模型仍然將偏見、誤解和私心納入了演算法,而人類的生活愈來愈受這些系統鋪天蓋地的管控。在數理邏輯至上的世界中,數學定律有絕對權威,數學家、電腦科學家與系統工程師彷彿神壇祭司,透過不透明的卡夫卡式黑箱,對芸芸眾生的未來作出神意的裁決。其決定即使是錯誤或有害,也不容質疑或申訴。

問題來了:這類數理模型之所以會存在且有商業價值,是因為它們一開始都是被設計用來自動化批量處理信息的特定程式,而且很多模型的根源來自於數學、化學與物理學等無機領域,而非生物學、心理學、政治經濟社會學等有機領域。在模型應用與結果詮釋上一旦出現偏差,將會加劇社會兩極分化,讓富者愈富、貧者愈貧,歧視與偏見在演算法的回饋路徑中被保存、複製、放大,往往出現反直覺、甚至反人性的嚴重後果。民營企業若將這類程式視為商業機密,不公開揭露演算法內部細節與誘因機制,往往讓數學公式成為卸除責任與保障官位的掩護與藉口,並且利用資訊科技創造出民眾關注的切身問題正在被解決的幻象,收割政治與商業利益。在最極端的情境,完全可以想像這些程式成為一座座用數學構建的袋鼠法庭(kangaroo court),透過各類物聯網監控技術與不透明的演算法「優化」資源分配,甚至可能在分子生物學的層次對人類進行分類、排序與缺席審判。這些源自人性黑暗面的大數據與人工智能,如果不受監管,有可能撕裂社會,甚至讓人類文明崩潰。但監管的標準該如何制定?誰來負責監管?如果監管者跟不上時代,甚至不可信賴,人類又該如何在AI專政的虛擬實境中維持人性尊嚴?

新芝加哥學派知名法學家Lawrence Lessig曾經提出,法律規範、社會習慣、市場秩序、科技架構是形塑個人與企業的社會經濟活動的四股「治理」(regulator)力量。Lessig指出,人類出生的實體世界受到物理、生化、社會與歷史文化的限制,是一個被給定(exogeneous)的外在環境,人類只能接受;但人類透過軟體工程與互聯網科技所設計建構的虛擬世界,是內稟(endogenous)於人類文明之中。維繫虛擬世界運行的種種行為規範與作業準則,都以程式碼形式存在,狀似無形,無所不在。如果程式即法律(Code is Law),那麼法律也是一種計算(Law is Computation)。人世間的各種交易態樣、合約選擇、權利義務關係,可以被視為各種計算理論上的「狀態」(state)。用人類語言寫的法律,與用機器語言寫的程式,定義了在不同狀態之間轉移的規則與相應的處置。在這個理論框架中,倫理、道德、義理人情等難以量化的概念,其實是環境的一部分。針對智能行為體的規範,不論該行為體是程式、個人或企業,都必須充分考慮行為體之間的博弈、競爭、演化,以及所有基於人性的行為體必然會出現的認知謬誤與系統內稟的統計偏差,並設計出對應的救濟與爭端解決機制。這份工作,人類責無旁貸。

更深一層看,何謂智能(intelligence)?笛卡兒曾說:我思,故我在,但抽象思維是否為證明高等智能存在的充份且必要條件?如何為智能分等級?用智能方法自動做出的選擇是否應該具有最終的法律效力?若把整個互聯網科技的發展視為人類加速己身演化的努力成果,那麼利用智能技術來鑑別、篩選、拔擢人才的嘗試,是否意味著從智人演化出大腦新皮質之後,將尼安德塔人拋棄在演化的歷史斷裂點,即將在互聯網演進的下一階段發生,從而定義出新舊人類之間不可跨越的鴻溝? 如果將智能定義為「在不同環境中實現目標的能力」,那麼人與人創造的程式,都可以被視為智能行為體,行為體之間的互動所導致的權利義務關係,又該如何界定?是否應該承認「AI權」與「人權」都是智能互聯網社會中不可侵犯的基本價值?在互聯網1.0的時代,沒有人知道網絡上的你是不是一條狗;在互聯網X.0的時代,誰會保障你不會像卡夫卡《審判》中的K先生死得像一條狗?

因為互聯網科技跨境的特質,這類議題本質上是全球性的,需要全球範圍的溝通、協調與合作。 取名自Weapons of Mass Destruction(大規模毀滅性武器)諧音的Weapons of Math Destruction,是否也需要一份核不擴散條約?面對益發混亂的國際局勢與現實主義地緣政治的回歸,霸權級資訊大國與互聯網巨頭競逐全球市場的鬥爭,讓透過全球網絡的人工智能治理(AI governance)成為一場不段進行中的革命,構成對人類巨大的挑戰。美國白宮在歐巴馬時代發佈的大數據機遇與公民權利研究報告中指出的五大方向,值得借鑒:

- 持續支持緩解演算法歧視的研究,建造公平、可問責的大數據應用系統,並發展數據應用的倫理框架

- 鼓勵市場參與者設計透明、可問責的演算法,允許失真數據的受害者尋求救濟的機制

- 提倡產業界與學術界關於演算法外部稽核與測試的研究發展,以確保人民享有公平待遇

- 推廣計算機科學與數據科學的廣泛參與、學習與公眾認知

- 充分考量公私部門在促進善用大數據的規則制定過程中的不同角色定位及期望

日本中央銀行總裁黑田東彥在2017年4月13日舉辦的一場人工智能與金融前沿研討會上曾說:面對新科技對社會經濟所造成的深層變革,政策制定者不應該過度憂心新科技的負面作用,而不去關注其正面效益。人類與AI應該互補,不能也不該對抗。人類的判斷往往受既有範式影響,有時對變化覺察不足,這正是AI的強項,可以透過客觀地調整因為主觀偏見所忽視的數據關連性與新趨勢。另一方面,直覺、常識與想像力,是目前人工智能最大的弱點。人類真正應該擔憂被AI取代的時候,是人類放棄獨立正面思考的時候。正如在17世紀提出計算機的法國哲學家巴斯卡在《沈思錄》所言:面對強大有力的宇宙,人是一根會思考的蘆葦(Man is but a reed, the most feeble thing in nature, but he is a thinking reed.)即使柔弱如蘆葦,仍可秉持高貴。希望難以量化,前途不可限量。命運沒有基因,夢想沒有極限。在《2001太空漫遊》中的HAL出現前,也許人類應該少擔心些數據,讓夢想與命運驅使我們繼續航向未知的遠方。

*作者為旅居香港的金融觀察家與專業投資人,源鉑資本(Kyber Capital)執行長。